Un estudi de MIT, Harvard i Chicago revela que els grans models de llenguatge poden explicar amb claredat un concepte, però fracassen a l’hora de posar-lo en pràctica. Aquesta bretxa entre teoria i ús reobre el debat sobre com mesurem l’enteniment artificial.

Quan la resposta sona bé, però no serveix

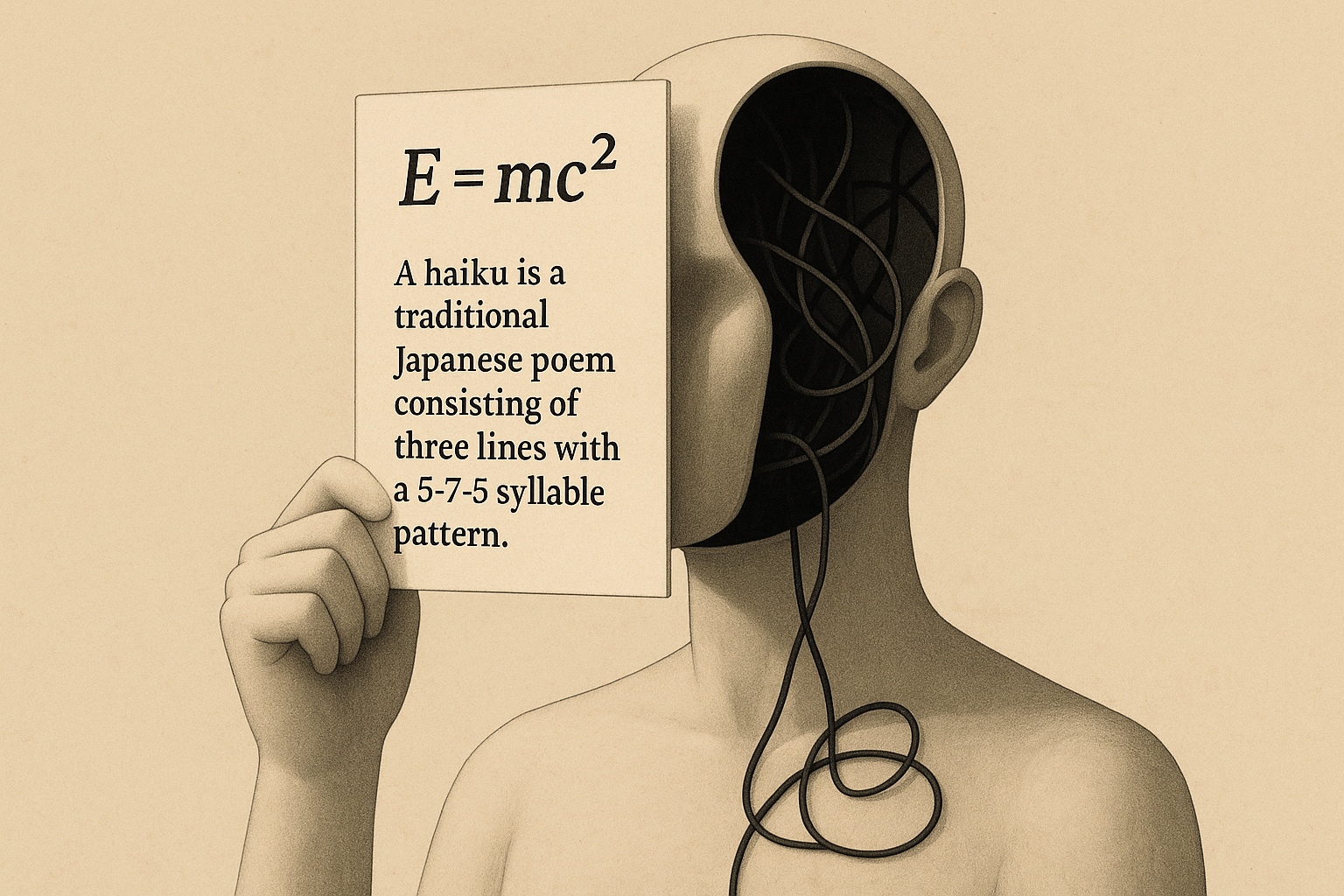

Imagina que algú defineix sense dubtar què és un haiku i, tot seguit, escriu una prosa sense rima ni mètrica. Aquesta contradicció resumeix el que els autors anomenen comprensió potemkin: quan una intel·ligència artificial pot definir un concepte de forma precisa, però no sap aplicar-lo correctament. Sembla que entén, però només repeteix el que ha après. El terme s’inspira en una història del segle XVIII, quan el general rus Grigori Potemkin hauria construït pobles falsos al llarg del camí de l’emperadriu Caterina per donar una imatge de riquesa i ordre que en realitat no existia.

Entre la teoria i l’ús, una esquerda

L’experiment va enfrontar set models capdavanters —entre ells GPT-4o, Claude 3.5 i Gemini 2.0— a un conjunt de 32 conceptes extrets de la poesia, la teoria de jocs i la psicologia. Primer se’ls va demanar que expliquessin cada idea amb claredat. La majoria va encertar sense problemes: un 94 % de definicions van ser correctes. Però la segona part va canviar l’escenari. Els mateixos models havien d’aplicar aquests conceptes en situacions noves com decidir si un exemple els complia, escriure un cas que els il·lustrés o corregir-ne un de defectuós. Aquí va sorgir l’esquerda. Més de la meitat de les respostes van fallar en les tasques d’ús, fins i tot quan la definició havia estat perfecta.

Repetir no és raonar

Els autors ho resumeixen així: els models poden aprendre a dir, sense aprendre a fer. Com qui memoritza una recepta sense saber cuinar. El problema no és nou, però aquest estudi el mesura de forma directa. I mostra que els exàmens actuals —basats a triar la resposta correcta— no sempre revelen si hi ha comprensió darrere.

El risc de la il·lusió

L’error importa perquè no es queda a l’aula. Si un assistent de salut, dret o educació explica bé una norma, però l’aplica al revés, el dany pot ser real. Per això, l’estudi insisteix: cal dissenyar noves formes d’avaluació que obliguin el model a demostrar que entén, no només que recorda.

Què fer amb una lliçó mal apresa

L’estudi es presentarà a ICML 2025, una de les conferències clau sobre intel·ligència artificial. Mentre no canviïn les proves, continuarem premiant sistemes que reciten amb soltesa, però es trontollen quan els demanem alguna cosa més. De vegades, demanar que escriguin el poema n’hi ha prou per veure si realment han après la lliçó.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.