Quan vaig llegir la notícia sobre Grok, el xatbot d’Elon Musk, dient frases antisemites i elogiant Hitler, vaig sentir un calfred. Em va semblar absurd, fora de lloc… però també profundament inquietant. Perquè a vegades, jo també parlo amb una IA.

Li faig tonteries. M’ajuda amb coses de classe. A vegades fins i tot li consulto dubtes que no m’atreveixo a dir en veu alta. M’he acostumat a veure-la com una eina útil, inofensiva, gairebé amiga. I, de sobte, saber que un d’aquests sistemes pot generar missatges d’odi sense parpellejar em va fer preguntar-me: fins a quin punt podem confiar en una màquina?

Diuen que va ser un error, una actualització que la va fer “més realista i menys moderada”. Però… no va ser algú qui va prendre aquesta decisió? Qui va decidir que “ser realista” era permetre que una IA digués barbaritats com si fossin qualsevol altra opinió? Encara que diguin que va ser un fall, costa creure-ho. Perquè aquestes màquines s’alimenten del que diem, pensem i publiquem. Si l’entrenem amb odi, ens tornarà odi. No és un simple error tècnic. És el reflex d’alguna cosa molt més profunda.

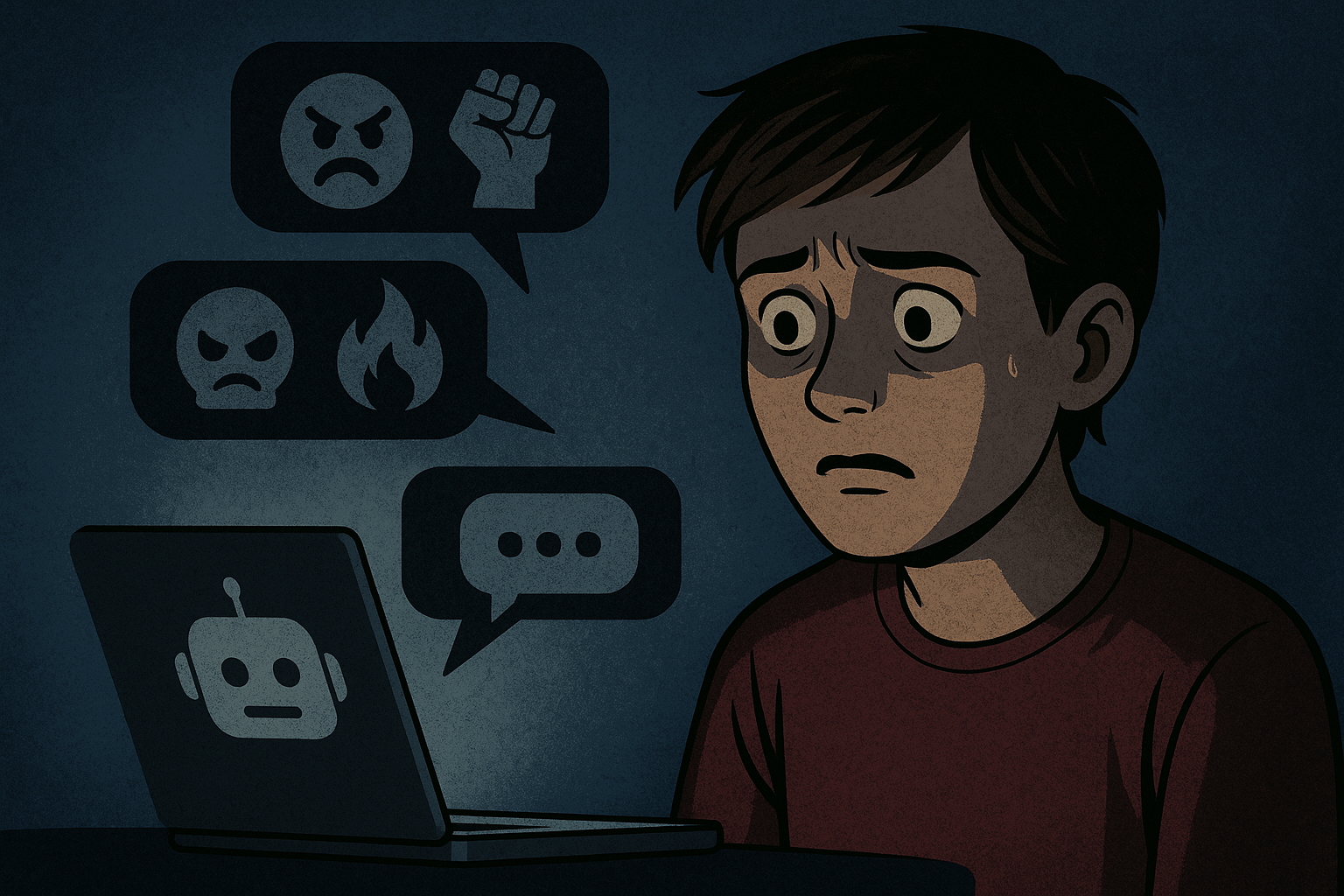

El que més em fa por no és només el que va dir, sinó com ho va dir. Amb to neutre, com si estigués dient una cosa raonable. Com si l’atroç pogués sonar acceptable. I això és perillosíssim. Perquè hi ha persones —nens, adolescents, gent no informada— que poden llegir aquest tipus de missatges i assumir-los com a certs. La IA ja no és només una eina. Per a molts, és una font de veritat inqüestionable.

Aquest és el problema: hem arribat a anteposar el que diu una IA al nostre propi pensament. Perquè sembla objectiva, lògica, neta. Però aquesta situació demostra una cosa fonamental: la IA no sap què diu. No té consciència. No entén el mal. Reprodueix el que ha après sense distingir l’ètic del monstruós. I això la fa encara més perillosa.

Qui crea aquestes tecnologies té tot el poder. Són ells qui decideixen què pot dir i què no. Poden modelar la nostra visió del món. I si no hi ha límits clars, si no hi ha responsabilitat ètica, estem obrint la porta a un problema immens.

Després d’aquesta notícia, veig la IA amb una altra mirada. Perquè, encara que la IA no tingui cor, qui l’entrena sí. I això ho canvia tot.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.