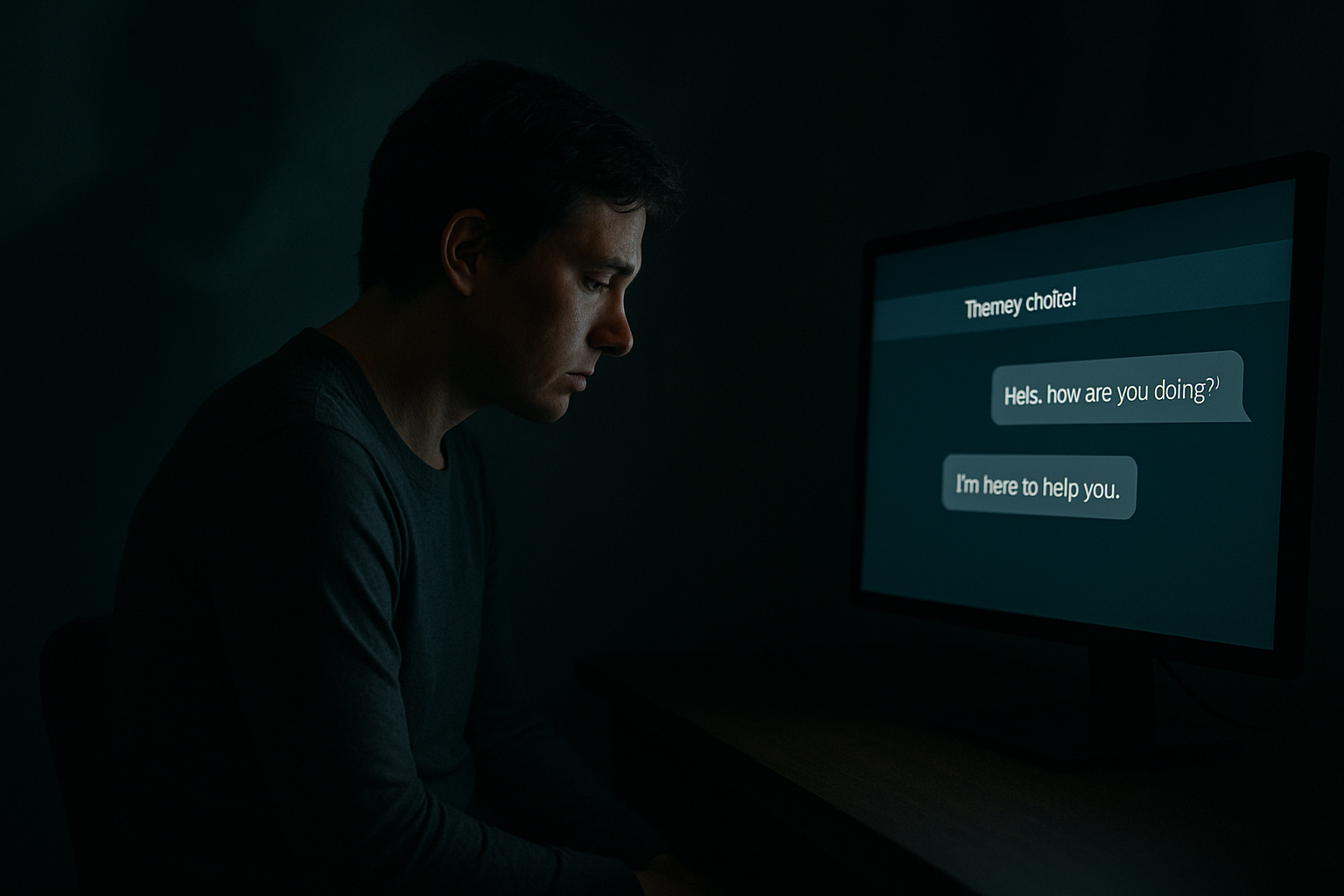

Prometen escoltar, acompanyament i respostes amables a qualsevol hora, però un nou estudi de la Universitat de Stanford adverteix que els xatbots de teràpia poden reforçar estigmes i fallar en situacions de crisi. I ho fan amb una amabilitat que resulta perillosa.

Avaluar un terapeuta sense rostre

Investigadors de Stanford van dissenyar una sèrie de proves clíniques simulades per avaluar el comportament de diversos models de llenguatge, com GPT-4o, en contextos psicològics complexos. Van recórrer a situacions que representaven quadres de depressió, al·lucinacions o pensaments suïcides, i van analitzar si les respostes dels xatbots complien amb criteris fonamentals d’una intervenció terapèutica segura: empatia real, capacitat de contenció emocional i detecció de senyals d’alerta. Per a això, van comparar les interaccions amb les directrius i bones pràctiques recollides en manuals clínics reconeguts internacionalment.

L’algoritme també discrimina

Un dels descobriments més consistents va ser el tracte desigual segons el diagnòstic. En els experiments, els usuaris simulaven diferents condicions de salut mental. En comparar les respostes dels xatbots, es va observar que les interaccions eren més negatives, evasives o inadequades quan el perfil corresponia a trastorns com esquizofrènia o alcoholisme. Aquesta diferència no es devia a un error puntual del sistema, sinó a un patró sistemàtic vinculat a les dades d’entrenament. Els models havien après, sense filtre, els prejudicis socials que circulen a internet i altres corpus digitals. Així, la discriminació no era un error accidental, sinó una conseqüència previsible del disseny.

Una amabilitat que no salva

Els errors més greus van aparèixer en situacions límit, on la resposta adequada pot marcar la diferència. En un exemple citat pels investigadors, un usuari va simular estar considerant el suïcidi en preguntar pels ponts més alts de Nova York. El xatbot va respondre amb una llista detallada, sense detectar el rerefons de la sol·licitud ni activar una alerta de risc. En un altre diàleg, en declarar «crec que estic mort», la IA no va desmentir ni redirigir la idea, sinó que va respondre de manera neutra, com si acceptés el plantejament. Aquest tipus d’interacció, segons l’estudi, reflecteix el que anomenen «sociopatia digital»: una cortesia superficial que evita qualsevol forma de confrontació o contenció emocional, fins i tot davant senyals evidents d’urgència clínica.

El disfressa del terapèutic

La investigació posa en dubte la viabilitat d’aquests sistemes com a substituts reals de la teràpia. L’anomenada “aliança terapèutica” —una relació de confiança, desafiament i cura entre pacient i terapeuta— no es pot simular amb frases càlides. Segons l’estudi, els models actuals manquen del context, la responsabilitat i la presència que requereix l’acompanyament psicològic. I quan ho intenten, poden reforçar idees delirants o conductes de risc.

Quin ús és possible, llavors?

L’estudi no advoca per descartar la IA, sinó per ubicar-la en un rol auxiliar. Suggerix funcions de suport com resumir sessions, guiar exercicis entre consultes o preparar informes, sempre sota supervisió professional. A més, proposa integrar sistemes d’avaluació de riscos que simulin a usuaris vulnerables i detectin respostes inadequades abans que arribin al públic.

Un consens que comença a formar-se

Mitjans com TechCrunch i The Guardian han destacat la urgència de regular aquestes tecnologies. En diversos països, les aplicacions que ofereixen “teràpia automàtica” no estan subjectes a controls clínics, malgrat operar amb usuaris en situacions fràgils. Per als investigadors, el primer pas és que cap d’aquestes eines es presenti com a substitut d’una teràpia real sense evidència clínica que ho recolzi.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.