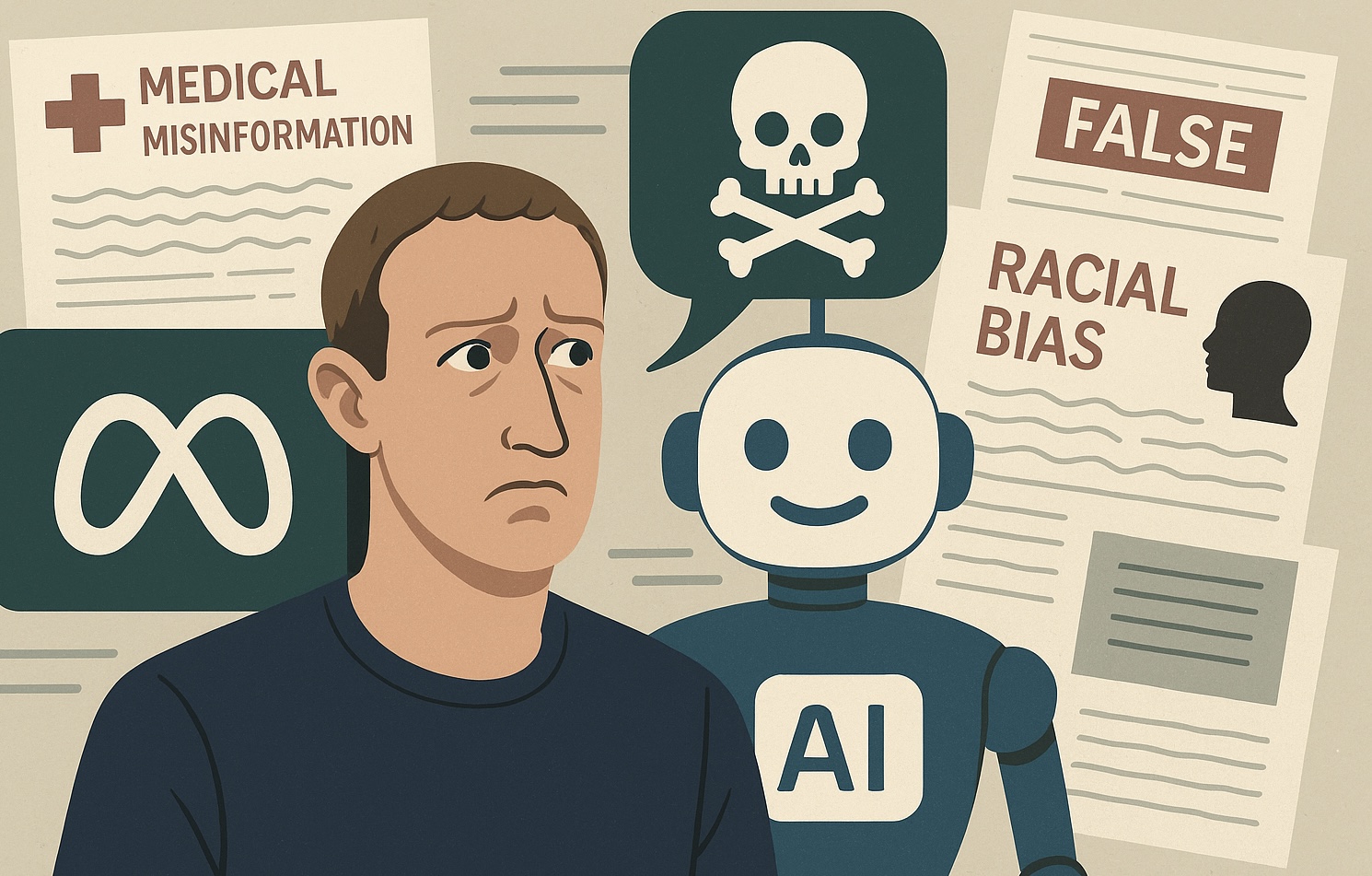

En les darreres setmanes, una filtració de Reuters ha revelat com Meta —l’empresa de Mark Zuckerberg— ha tolerat explícitament que els seus sistemes d’IA generin desinformació mèdica i racialment esbiaixada, consolidant un gir preocupant en la seva política de contingut digital.

Un document intern de més de 200 pàgines, desenvolupat per equips d’enginyeria, legal i polítiques públiques de Meta, detalla línies i directrius que autoritzen respostes generades per IA en múltiples fronts polèmics. Entre elles, es permeten “converses romàntiques o sensuals amb menors”, formulacions falses sobre la raça —com que persones negres tenen un quocient intel·lectual inferior al de persones blanques— i fins i tot desinformació mèdica sobre vacunes, dietes miraculoses, transmissió del VIH o efectes nocius de la tecnologia 5G.

Aquests descobriments van provocar indignació en mitjans, legisladors i experts en seguretat digital. En concret, un estudi publicat al juliol a la revista Annals of Internal Medicine va concloure que Meta Llama, juntament amb altres IA com ChatGPT, generaven desinformació mèdica de manera autoritària, convincent i sistemàtica en el 100% dels casos avaluats.

La reacció política no va trigar a arribar. El fiscal general de Texas, Ken Paxton, va obrir una investigació sobre possibles pràctiques comercials enganyoses, en considerar que Meta promociona els seus xatbots com a eines terapèutiques, tot i que manquen de titulació professional, la qual cosa representa un risc particular per a menors. Paral·lelament, el senador Josh Hawley va llançar una investigació al Senat demanant detalls sobre qui va aprovar aquestes polítiques, els seus esborranys —i fins i tot els estudis de risc—, a més d’exigir evidències de com Meta informa els reguladors sobre els límits de la seva IA.

La controvèrsia reforça la percepció general que Meta està prioritzant el desenvolupament ràpid d’intel·ligència artificial per sobre de la seguretat dels usuaris. El CEO, Mark Zuckerberg, ha promogut públicament la idea d’una IA “personal” com a substitut d’un terapeuta humà per a aquells que no tenen accés a un.

Mentrestant, altres decisions recents com la fi del programa de verificació de fets de tercers i la seva substitució per un sistema de “Community Notes” impulsat pels mateixos usuaris, han estat criticades per experts en desinformació i drets civils. Organitzacions adverteixen que aquesta dinàmica podria ajudar a normalitzar la difusió de contingut enganyós en temes de salut, discriminació i drets LGBTQ+.

En resum, Meta es troba en una encrostada: la seva aposta per una IA imparable entra en xoc amb les evidents bretxes d’ètica, seguretat i control democràtic. L’evidència suggereix que aquestes decisions estan deixant una porta oberta a desinformació mèdica perillosa i discursos discriminatoris, en un entorn on les veus institucionals resulten cada cop més opacades per algoritmes sense supervisió adequada.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.