Anthropic, la companyia darrere de l’assistent conversacional Claude, ha implementat una nova política de dades que obligarà a tots els seus usuaris a decidir abans del 28 de setembre de 2025 si desitgen que les seves converses siguin utilitzades per entrenar els seus models d’intel·ligència artificial. En cas de no fer-ho, perdran accés al servei. Aquesta mesura marca un gir substancial enfront de la pràctica anterior, on els xats dels usuaris s’eliminaven després de 30 dies, excepte aquells revisats per raons de seguretat.

A partir d’ara, Anthropic mantindrà les converses —incloent-hi sessions de xat i codi— fins a cinc anys en cas que els usuaris no optin per excloure’s de l’entrenament de models. L’actualització s’aplica a les versions de consumidor: Claude Free, Pro, Max i Claude Code, mentre que comptes corporatives com Claude Gov, Claude for Work o integracions via API (per exemple, Amazon Bedrock o Google Cloud Vertex AI) es troben exemptes.

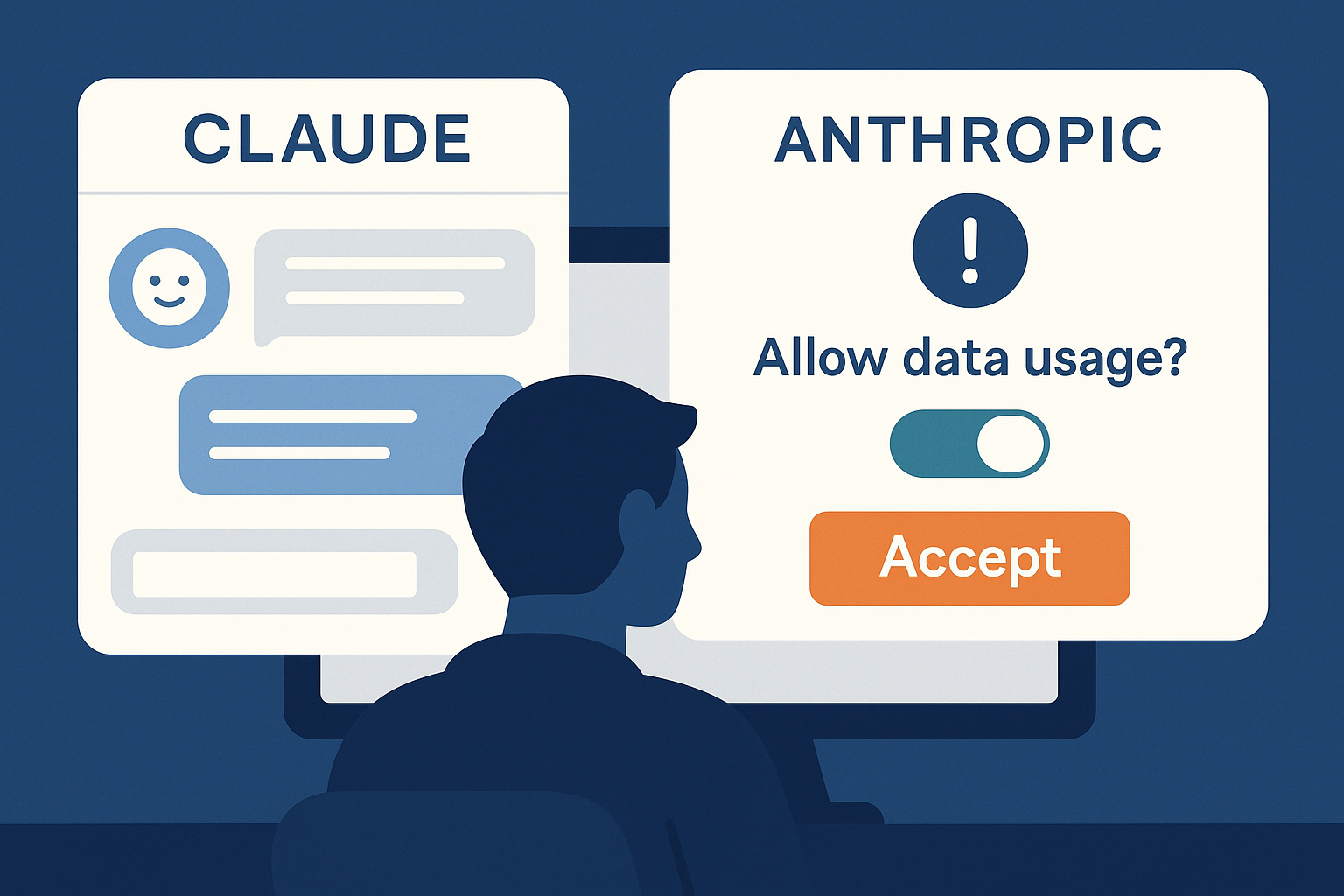

Els usuaris rebran un avís emergent —etiquetat com “Updates to Consumer Terms and Policies”— on trobaran un botó gran de «Accept» i un interruptor més petit, activat per defecte, que habilita l’ús de les seves dades per a entrenament. Aquesta interfície ha estat criticada per experts en privacitat pel seu disseny poc transparent, que podria induir a que els usuaris acceptin sense adonar-se’n.

Anthropic defensa que aquest enfocament aporta beneficis clars: refinar els sistemes de detecció de contingut nociu, millorar capacitats de raonament i codificació, i en conseqüència, oferir models més segurs i potents per a tots els usuaris que participin. Subratllen també que només s’utilitzaran les dades de noves converses o les reactivades; les sessions antigues o inactives no seran usades tret que es reprenguin.

No obstant això, aquesta modificació ha generat inquietud en defensors de la privacitat, els quals denuncien que Anthropic ha passat d’un model d’opt-in a un de opt-out per a l’entrenament de models, el que representa una regressió significativa en termes de consentiment informat. A més, s’assenyala que, malgrat que Anthropic assegura que no ven les dades i que empra processos automàtics per filtrar informació sensible, una vegada les dades s’utilitzen, no es poden recuperar ni eliminar retrospectivament.

Aquest moviment ocorre en un context competitiu on Anthropic busca mantenir-se a la vanguardia enfront de rivals com OpenAI i Google. Mantenir converses d’usuari com a font d’entrenament ofereix un avantatge estratègic per al refinament dels seus models, el que subratlla la pressió que enfronten aquestes empreses en l’entorn de la IA generativa. Paral·lelament, aquest enfocament suscita dubtes sobre l’extensió real del consentiment de l’usuari i la transparència amb què s’està exercint.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.