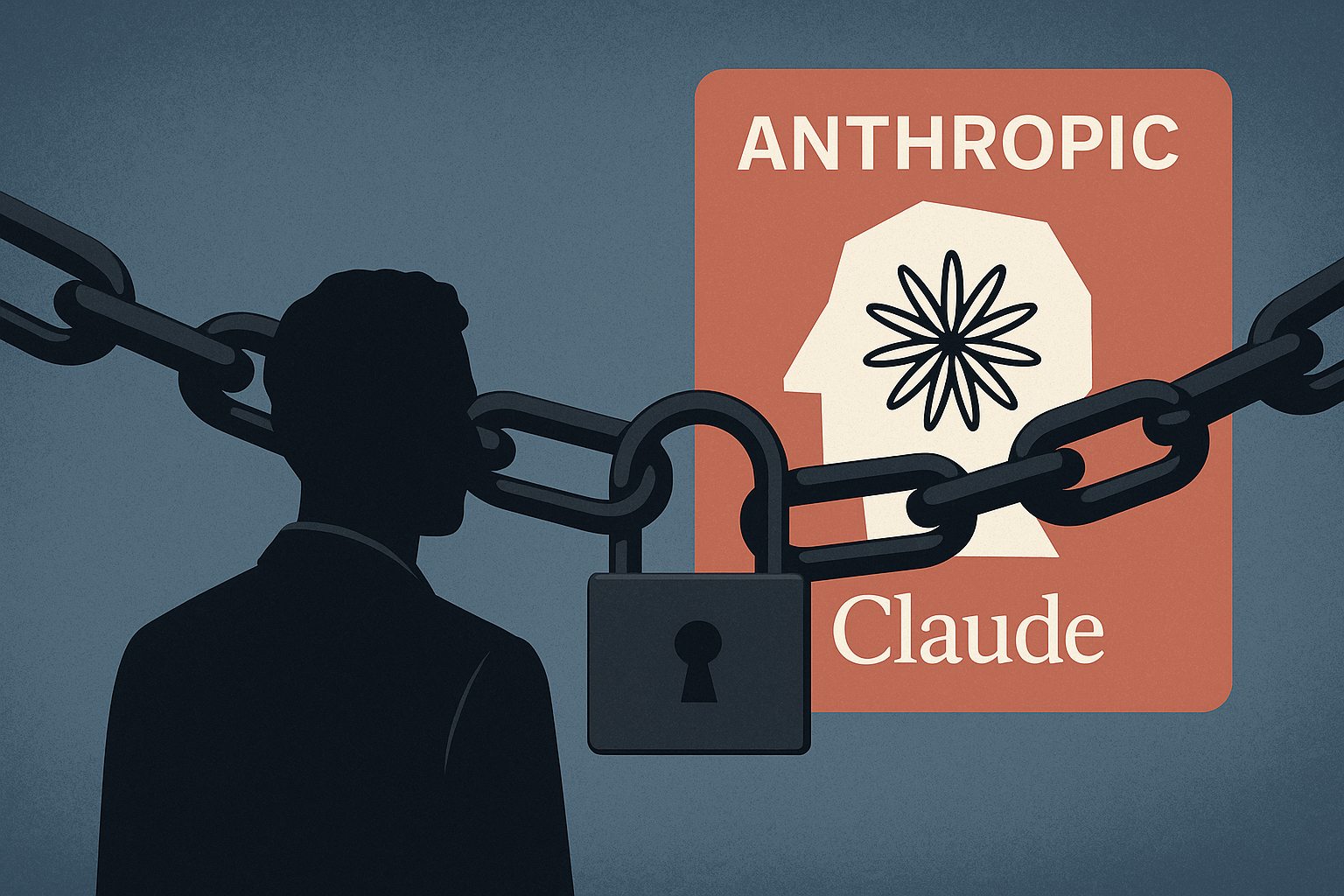

Quan una companyia d’intel·ligència artificial tanca l’accés a una altra, el gest va més enllà del tècnic. Aquesta setmana, segons ha pogut saber Wired, Anthropic va revocar l’ús de la seva API Claude a OpenAI després de descobrir que l’equip d’aquesta última estava utilitzant les seves eines de codi per afinar GPT-5. La decisió marca un nou capítol en una competència que ja és estratègica, comercial i filosòfica.

Claude com a mirall de GPT-5

OpenAI no feia servir la versió pública de Claude, sinó accessos específics que permeten integrar el model en fluxos interns. A través d’aquesta via, va sotmetre Claude a proves en programació, escriptura i maneig de temes delicats com autolesions o contingut abusiu. Tot, segons Anthropic, amb l’objectiu de calibrar i comparar el seu propi model en desenvolupament: GPT-5. Un benchmarking que, des del punt de vista contractual, hauria creuat límits.

Els termes que van saltar pels aires

Anthropic al·lega que les seves condicions de servei prohibeixen utilitzar Claude per crear serveis competidors, entrenar altres models o replicar la seva tecnologia. Encara que comparar sistemes és pràctica comuna en el sector, l’empresa sosté que fer-ho des d’una posició interna, amb accés privilegiat, trenca l’acord. El resultat: cancel·lació immediata de l’accés.

OpenAI respon: competir és avançar

Des d’OpenAI, la resposta ha estat mesurada però crítica. Al·leguen que comparar models és vital per avaluar seguretat, detectar fallades i millorar capacitats. Encara que reconeixen el dret d’Anthropic a limitar l’ús, subratllen que la seva pròpia API continua oberta a avaluacions externes. En un gest conciliador, asseguren que podran continuar fent proves limitades amb Claude per a garanties de seguretat, encara que no queda clar sota quines condicions.

Claude Code i altres tensions prèvies

El conflicte no és aïllat. Fa setmanes, Anthropic també va vetar a Windsurf, una startup centrada en codi, després de rumors d’una possible adquisició per part d’OpenAI. Jared Kaplan, director científic d’Anthropic, va ser directe: “Seria estrany vendre Claude a OpenAI”. A més, el mateix dia del tall, l’empresa va anunciar límits setmanals per a l’ús de Claude Code, al·legant alta demanda i quatre interrupcions recents del servei.

Les APIs ja no són neutrals

El cas reflecteix un dilema creixent. Les APIs permeten créixer, però també exposen. Empreses com Meta o Salesforce han restringit accessos en el passat per evitar usos que comprometin el seu avantatge competitiu. En el cas de la IA generativa, on l’entrenament i avaluació depenen de grans volums d’interacció, la protecció de models es converteix en estratègia.

No només models, també maneres de pensar

La història també té un rerefons. Anthropic va néixer d’una escissió d’OpenAI. Els seus fundadors van impulsar una visió més enfocada en la seguretat i la transparència, davant del ritme agressiu de la seva predecessora. Claude i ChatGPT no només competeixen per usuaris, sinó per imposar una forma d’entendre la intel·ligència artificial.

Qui imposa les regles del joc

Tancar una API no és només un gest tècnic: és una forma de marcar límits en un entorn on les normes encara s’escriuen sobre la marxa. Anthropic defensa els seus límits contractuals; OpenAI insisteix en la necessitat de comparar per avançar. Entre ambdós, queda la pregunta: què significa competir netament en un sector on el codi és invisible però les decisions són polítiques?

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.