Des d’un despatx a Sant Sebastià, una startup que fins fa poc treballava gairebé en silenci ha donat un cop sobre la taula. Multiverse Computing ha presentat CompactifAI, una tecnologia que redueix els grans models de llenguatge sense que perdin capacitat de resposta. Fins a un 95% més petits. I ho fa just on més es veu, a Amazon Web Services. L’objectiu no és competir per mida, sinó per lleugeresa. Perquè no tothom es pot permetre una intel·ligència artificial XXL.

La promesa de les xarxes tensorials

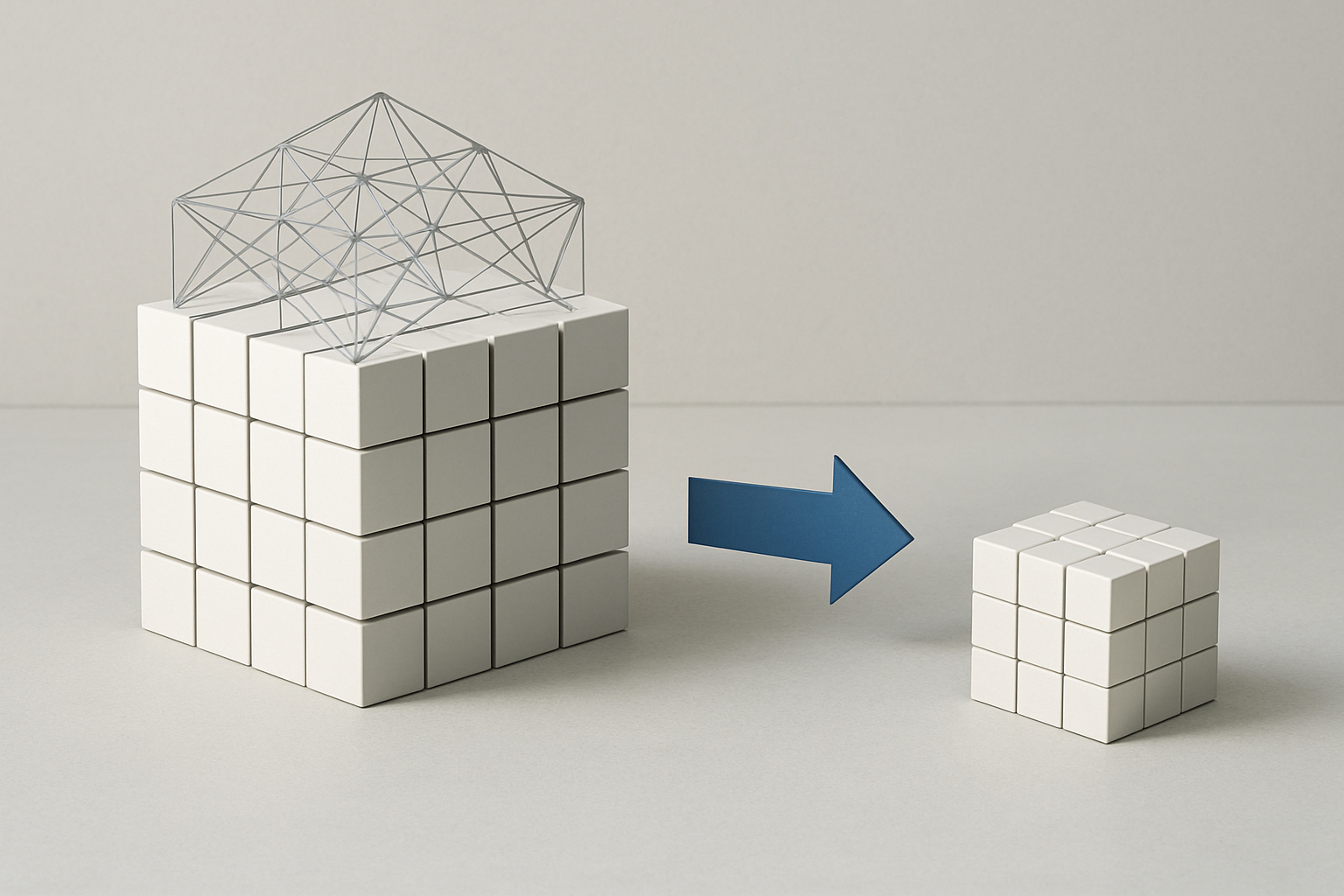

CompactifAI no elimina, reorganitza. Utilitza xarxes tensorials —estructures matemàtiques que en física quàntica serveixen per descriure sistemes complexos— per comprimir els models sense esborrar informació. És com encaixar una manta en una motxilla sense deixar arrugues. En comptes de reduir paràmetres a cegues, els redistribueix amb precisió. Menys memòria, menys cost, menys espera. Però amb els mateixos reflexos. O gairebé. Segons l’empresa, el model conserva el 99% de la seva precisió.

De laboratori basc a aparador global

L’API ja s’ofereix a AWS, cosa que permet executar versions comprimides de LLaMA, Mistral o DeepSeek des de qualsevol entorn compatible. Sense instal·lar res. Sense comprar servidors. N’hi ha prou amb una connexió. Això significa que petites empreses, administracions públiques o centres educatius poden accedir a models abans reservats a gegants. Una IA més repartida, menys elitista. La compressió, en aquest cas, també és un gest polític.

215 milions, una aposta que es nota

Multiverse ha aconseguit que la teoria es tradueixi en confiança. Al juny va tancar una ronda de finançament Sèrie B de 189 milions d’euros. Inversors com HP Tech Ventures, Toshiba o Bullhound Capital van entrar per escalar la tecnologia. Però el suport més simbòlic va venir del Govern espanyol amb 59,2 milions a través del PERTE Chip, amb entrada directa en l’accionariat. Una aposta per la sobirania tecnològica, però també per mantenir talent i infraestructura a casa.

Comprimir també obre esquerdes

Reduir mida sense perdre precisió sona bé. Però la compressió no és màgica. Què passa amb els matisos? Funcionen igual en català que en anglès? En contextos tècnics o sanitaris? Les proves internes són prometedores, però falta validació independent. I després hi ha l’altra pregunta, què passa quan qualsevol dispositiu pot executar una IA avançada? Quins controls, quins límits, quins usos?

Una estratègia diferent de la de la resta

Mentre OpenAI i Anthropic continuen augmentant la mida dels seus models, Multiverse va en sentit contrari. On altres engrandeixen, ells afinen. És una manera de desmarcar-se, però també d’adaptar-se. No tothom té GPUs, i no tota IA necessita córrer en centres de dades. Aquí, la compressió és una forma d’inclusió. I la seva aliança amb AWS permet arribar lluny sense dependre d’infraestructura pròpia. No és David contra Goliat. És una altra lliga.

IA lleugera, però amb pes específic

CompactifAI és com un llibre de mil pàgines en edició de butxaca. No canvia el contingut, però canvia qui pot portar-lo a sobre. Estem davant d’una intel·ligència artificial que cap a la mà i actua amb precisió quirúrgica? O davant d’una nova fase d’expansió sense filtre? Les eines estan llestes. La decisió —com gairebé sempre— depèn de com, on i perquè s’utilitzin.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.