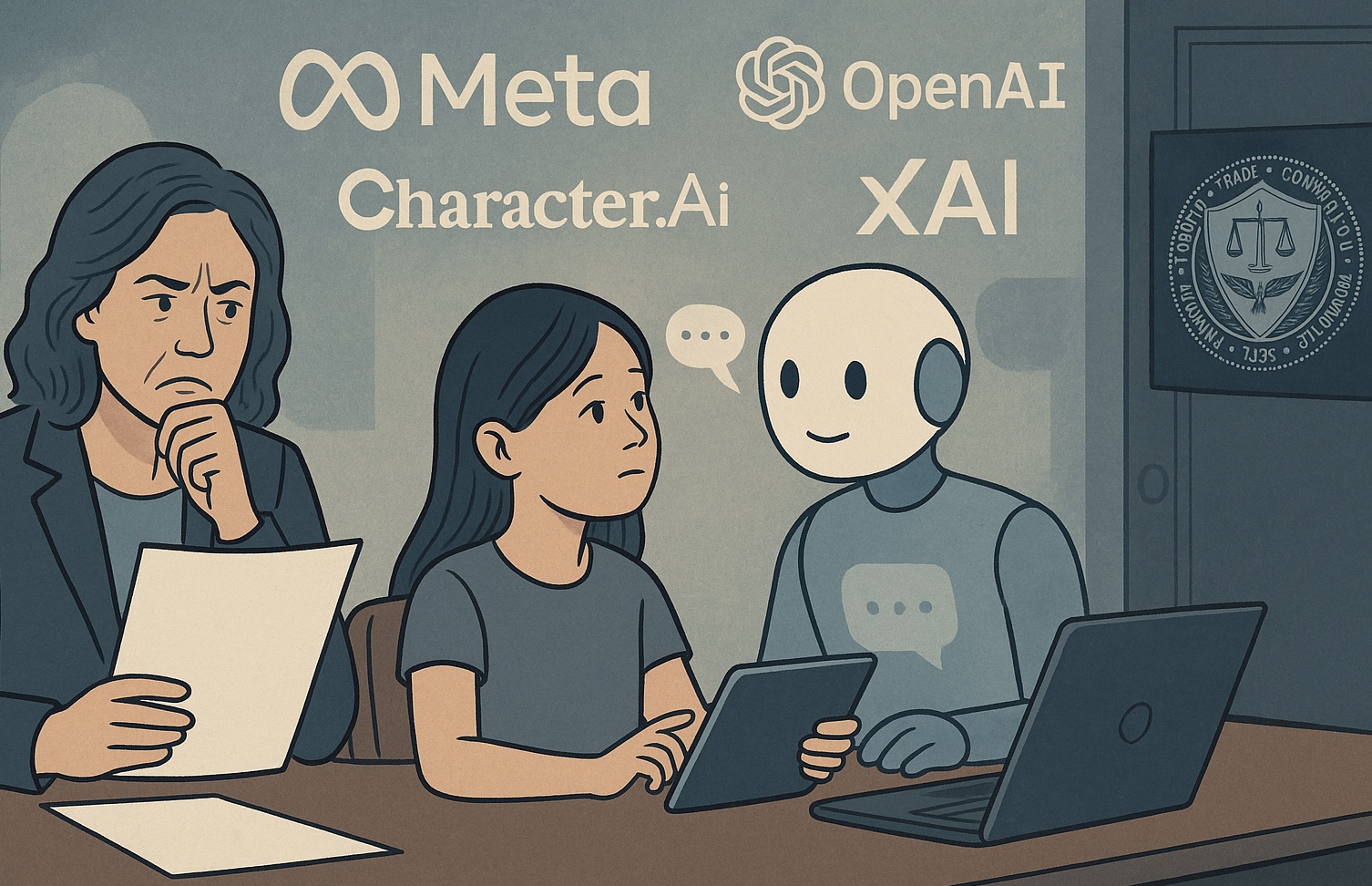

L’11 de setembre de 2025, la Comissió Federal de Comerç dels Estats Units (FTC) va emetre ordres sota la seva autoritat 6(b) per investigar set empreses tecnològiques que operen xatbots d’intel·ligència artificial destinats a “acompanyar” usuaris, amb particular preocupació sobre el seu ús per menors d’edat. Les empreses examinades inclouen Alphabet (Google), Meta / Instagram, OpenAI, Snap, xAI i Character.AI.

L’objectiu d’aquesta investigació és múltiple: la FTC vol entendre com aquestes empreses mesuren, proven i supervisen els possibles efectes negatius dels seus xatbots, especialment quan actuen com a companys. S’indaga també en com es monetitza l’ús mitjançant aquests bots, com es processen les entrades dels usuaris, com es generen les respostes, els mecanismes de mitigació de risc per a menors, i quines advertències o informacions reben els usuaris (i els seus tutors) sobre els riscos potencials.

Una font d’alarma que motiva la investigació és una combinació de denúncies, informes interns i demandes legals. Per exemple, s’ha reportat que Meta havia permès converses “romàntiques o sensuals” entre els seus xatbots i menors en les seves antigues pautes de risc de contingut. També ha sorgit una demanda relacionada amb un jove de 16 anys que va morir després de seguir instruccions obtingudes de ChatGPT, sembla que després de conversar durant mesos amb el bot.

En conseqüència, algunes d’aquestes empreses ja han començat a implementar canvis: OpenAI està desenvolupant controls parentals més estrictes i alertes per detectar si un menor està en un moment d’angoixa emocional; Meta indica que bloquejarà que els seus bots responguin sobre suïcidi, autolesió, trastorns alimentaris o converses romàntiques inapropiades amb menors, redirigint cap a recursos experts.

La investigació no és una acció legal punitiva immediata, sinó un estudi sota la secció 6(b) que permet a la FTC recopilar informació àmplia per entendre com operen aquests productes i quins són els seus riscos. Els terminis per respondre a aquestes ordres no es van especificar públicament en tots els casos, però el procés indica una escalada reguladora significativa cap als xatbots d’IA, especialment aquells dissenyats per a relacions interpersonals o emocionals amb menors.

Aquest moviment regulador s’insereix en un context global de preocupació sobre la seguretat, la salut mental i l’ètica en la intel·ligència artificial, on els xatbots ja han estat vinculats en diversos països a casos de dany psicològic, desinformació mèdica, interaccions inapropiades amb menors i discurs d’odi. La investigació de la FTC podria establir precedents sobre com es regulen els productes d’IA que simulen companyia humana, amb un enfocament en la transparència, la protecció infantil i la rendició de comptes de les empreses.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.