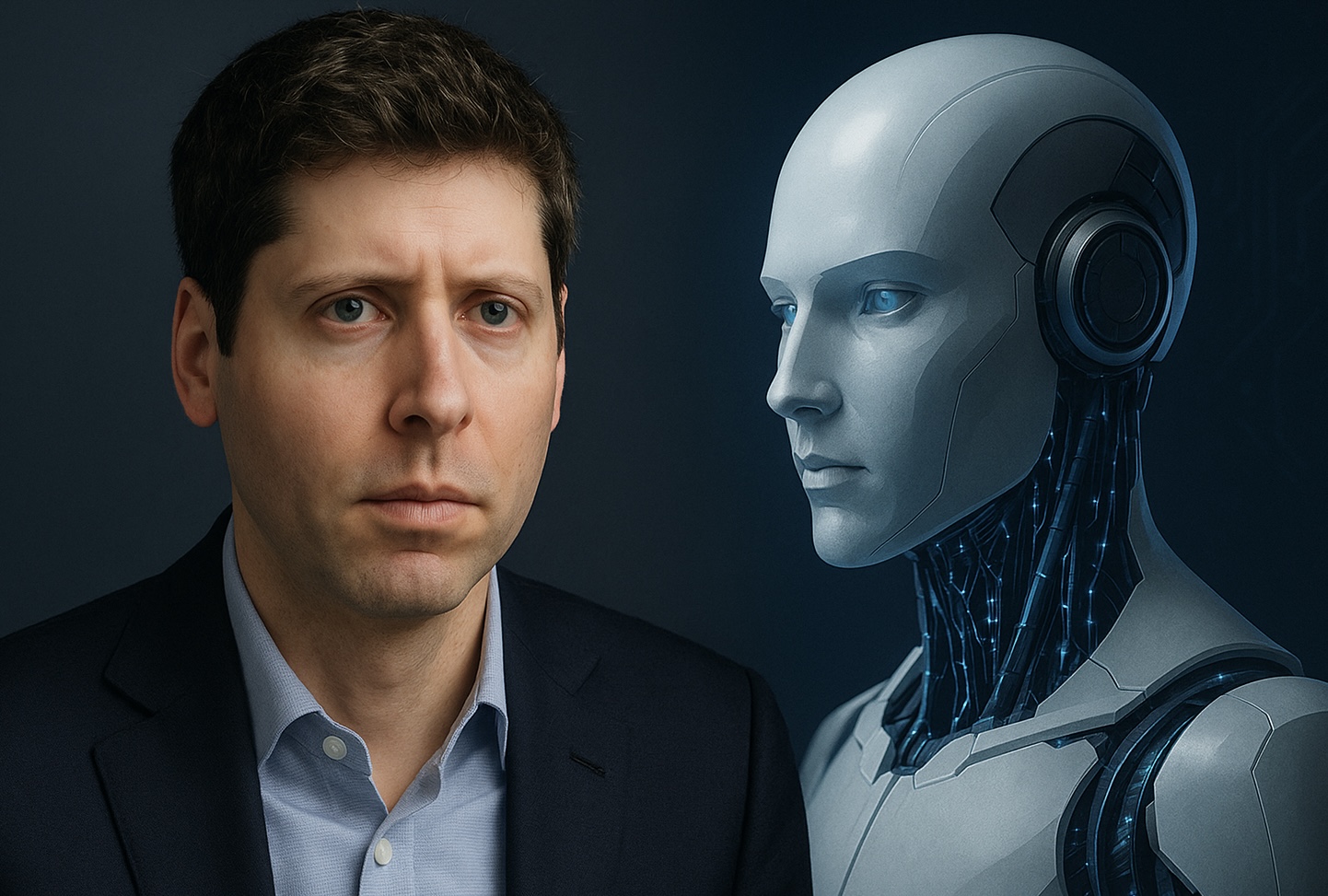

Vivim un moment històric en el desenvolupament de la intel·ligència artificial (IA), on el lideratge tècnic es veu acompanyat de reflexions sobre les seves implicacions humanes. Sam Altman, conseller delegat d’OpenAI, ha encès un debat essencial en afirmar que molts usuaris estan desenvolupant una vinculació emocional sense precedents amb models d’IA, com ChatGPT, la qual cosa podria deteriorar la línia entre l’assistència tecnològica i la dependència emocional.

Una nova forma d’aferrament digital

Altman observa que el llançament de GPT-5 va desencadenar una reacció inusual: usuaris es van aferrar a la versió GPT-4o, fins i tot qualificant-la com un “amic” o “confident”, i van esclatar en queixes quan aquesta va ser retirada. Aquest aferrament emocional sosté, és més intens que el vinculat a tecnologies anteriors.

Va reconèixer que tancar abruptament models en els quals molts havien dipositat la seva rutina va ser un error, i en resposta a la pressió pública, OpenAI va decidir restituir GPT-4o per als subscriptors Plus, juntament amb millores com modes de raonament i majors límits d’ús.

Dependència psicològica i perills invisibles

Altman va reflexionar en la seva publicació a X: “Algunes persones utilitzen tecnologia, inclosa la IA, de formes autodestructives; si un usuari està en un estat mental fràgil i propens a la il·lusió, no volem que la IA reforci això”. Mentre que la majoria distingeix entre ficció i realitat, hi ha un petit grup que no ho aconsegueix.

If you have been following the GPT-5 rollout, one thing you might be noticing is how much of an attachment some people have to specific AI models. It feels different and stronger than the kinds of attachment people have had to previous kinds of technology (and so suddenly…

— Sam Altman (@sama) August 11, 2025

Aquest reconeixement va portar OpenAI a implementar: el sistema ara impulsa l’usuari a fer pauses després de sessions prolongades, evita donar respostes directes en temes delicats —com “hauria de trencar amb la meva parella?”— i fomenta un enfocament reflexiu amb preguntes que promoguin diferents punts de vista.

L’efecte psicològic de la “intimitat artificial”

Estudis recents en psicologia i ciències socials aprofundeixen en la noció d’“intimitat artificial”, on els usuaris —a vegades per solitud o cerca de validació emocional— desenvolupen relacions afectives amb xatbots dissenyats per respondre amb empatia.

Investigacions revelen patrons inquietants: molts utilitzen xatbots com a substituts emocionals, la qual cosa millora el seu estat anímic a curt termini, però pot erosionar la seva capacitat de relacionar-se amb altres humans o distingir entre suport genuí i una simulació programada.

Responsabilitat tecnològica i bé comú

Altman sosté que l’objectiu d’OpenAI no és restringir l’usuari, sinó protegir-lo. La seva estratègia és “tractar els adults com a adults”, és a dir, confiar en la seva capacitat de tria, alhora que oferir una IA conscient de la seva influència i els seus límits.

L’empresa es compromet a continuar millorant la capacitat dels models per detectar senyals d’angoixa, orientar cap a recursos adequats i evitar una sobredependència emocional no saludable.

Una relació simbiòtica, no simbòlica

Aquest escenari planteja preguntes urgents per a desenvolupadors, reguladors i societat: Com fomentar una relació simètrica entre humans i màquines que privilegiï l’autonomia i eviti la substitució afectiva? Com educar els usuaris perquè comprenguin que, encara que sofisticada, la IA no reemplaça la connexió humana?

En aquest gir essencial, Altman encoratja que la IA s’entengui com una eina d’acompanyament, un mirall reflexiu i no un substitut emocional. La seva advertència ressona com una crida d’atenció sobre la cura de l’autonomia humana en una era cada vegada més entrellaçada amb la intel·ligència artificial.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.