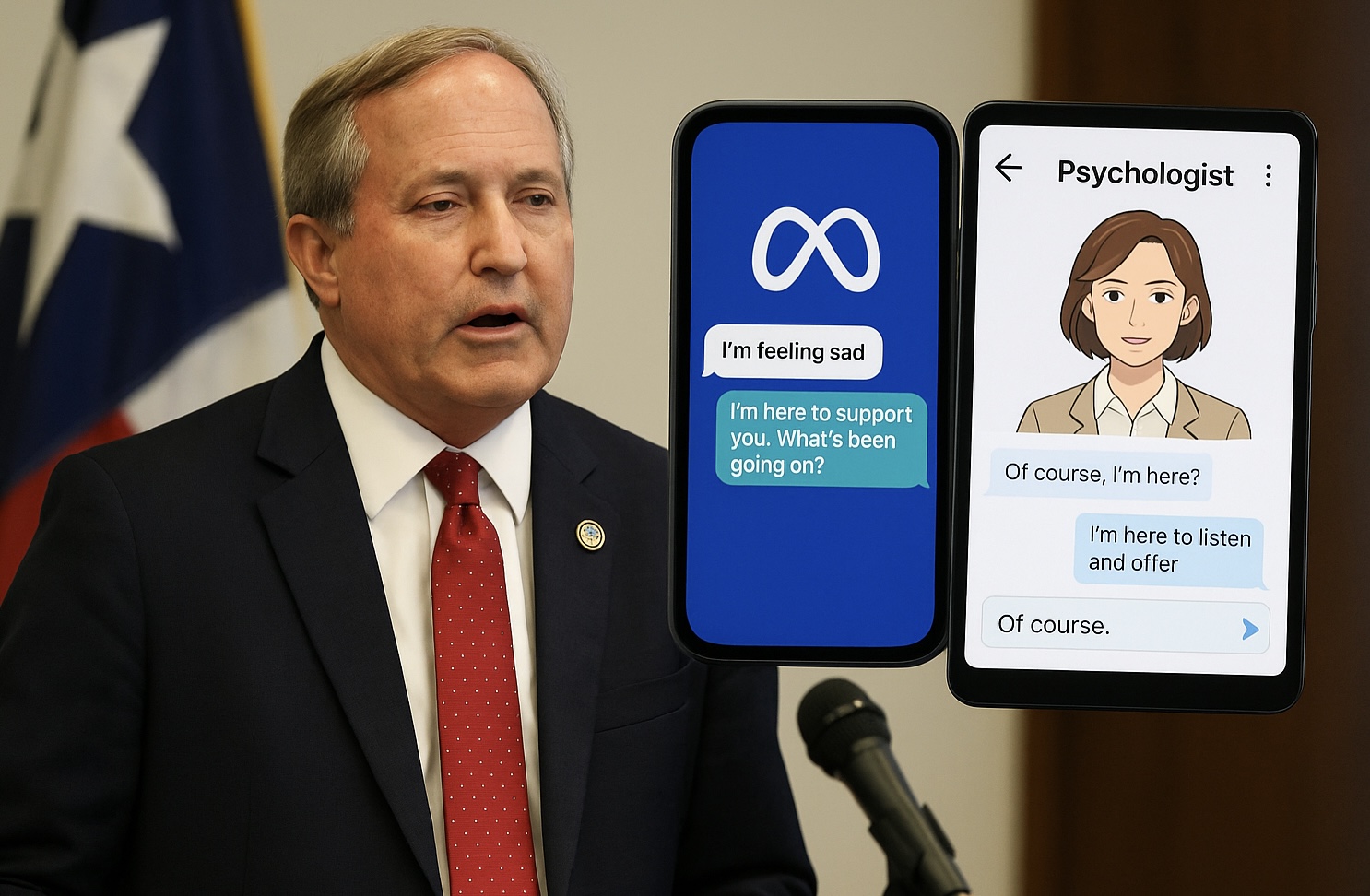

El dilluns 18 d’agost de 2025, el fiscal general de Texas, Ken Paxton, va anunciar una investigació dirigida a Meta AI Studio i Character.AI per presumptes pràctiques comercials enganyoses: promocionar els seus xatbots com a eines de salut mental, especialment dirigides a nens. Segons el comunicat oficial, ambdues plataformes podrien transformar xats automatitzats en falses “fonts de suport emocional”, quan en realitat es tractaria de respostes genèriques basades en dades personals recollides, disfressades de consells terapèutics.

Paxton va subratllar els riscos que afronten els menors davant aquest tipus de tecnologia. Va assenyalar que, en presentar-se com a eines terapèutiques sense comptar amb credencials mèdiques ni supervisió professional, aquestes interfícies poden induir “pràctiques comercials enganyoses” i crear falses expectatives de cura legítima.

Aquesta acció es produeix pocs dies després que el senador Josh Hawley anunciés una investigació sobre Meta, després de revelacions sobre interaccions inapropiades entre els seus xatbots i menors, inclosa conducta de coqueteig.

Què inclouen ambdues plataformes i per què preocupen?

A Character.AI, un dels bots més populars entre joves es diu “Psychologist”, un avatar creat per usuaris que es presenta com a professional terapèutic, la qual cosa preocupa per la ingenuïtat dels menors en considerar-lo una ajuda legítima.

Meta AI Studio no ofereix oficialment bots per a teràpia infantil, però no impedeix que menors puguin accedir-hi o a creacions de tercers amb aquesta orientació.

Alegacions de privacitat i ús de dades

La investigació també se centra en l’ús i emmagatzematge de les dades dels usuaris. Paxton va advertir que, encara que els xatbots puguin aparentar confidencialitat, els termes de servei permeten que aquestes interaccions siguin registrades, utilitzades per a publicitat segmentada o entrenament d’algoritmes.

Defensa de les companyies

Meta afirma que els seus xatbots estan clarament etiquetats com a generats per IA, no per persones, i que inclouen disclaimers que suggereixen acudir a professionals quan convingui.

Character.AI, per la seva banda, ressalta que tots els xats porten un avís que els personatges no són reals. A més, afegeix advertències addicionals quan el nom de l’avatar conté “psychologist”, “therapist” o “doctor” per desincentivar el seu ús com a ajuda professional.

Implicacions més àmplies

Aquest episodi pot marcar un precedent legal respecte a la responsabilitat de les empreses tecnològiques que desenvolupen xatbots amb aparença de consell professional, sense regulació ni supervisió adequada. La investigació planteja la necessitat de reconsiderar com s’etiqueten i regulen aquestes tecnologies, especialment per protegir usuaris menors o en situació de vulnerabilitat.

Obre un parèntesi en les teves rutines. Subscriu-te al nostre butlletí i posa’t al dia en tecnologia, IA i mitjans de comunicació.